Ce qu’il faut retenir du RIA

L’IA, dont l’utilisation est croissante dans les entreprises de tous les secteurs d’activité, tend à être de plus en plus réglementée. En Europe, le RIA combiné avec d’autres règlementations comme le RGPD ou la propriété intellectuelle, constitue désormais le cœur de cette réglementation.

L'entrée en vigueur de la loi sur l’IA le 01/08/2024 pose d’importants défis pour les organisations.

Les exigences sont complexes, mais peuvent être mises en œuvre de façon vertueuse tout en favorisant l’innovation en utilisant les bonnes approches et en anticipant suffisamment son programme de conformité.

Chez PwC, notre cadre de gouvernance de l’intelligence artificielle combine expertise technique, connaissances juridiques et expérience en matière de conformité avec les exigences spécifiques du RIA. Nous aidons nos clients à construire des systèmes holistiques de gouvernance de l’IA, leur permettant de naviguer dans et de se conformer efficacement à ce paysage réglementaire complexe.

Le RIA a des répercussions importantes sur les entités régulées

Les organisations développant et/ou déployant des systèmes d’IA sur le marché européen doivent désormais se conformer à différentes obligations notamment de gestion des risques, de gouvernance, de transparence et de sécurité.

En effet, proposé par la Commission européenne, le règlement sur l’IA entré en vigueur le 1er août 2024 vise à établir des règles harmonisées dans toute l‘Union Européenne pour le développement et le déploiement des systèmes d’IA. Une période de transition de 24 mois est prévue pour la mise en œuvre des exigences qui seront appliquées de façon progressive et dont la méconnaissance pourra être sanctionnée par de lourdes peines d’amende.

Ainsi, les obligations relatives à l’acculturation et aux systèmes d’IA interdits s’appliquent dès le 2 février 2025 tandis que la plupart des obligations à la charge des fournisseurs et déployeurs de systèmes d’IA à haut risque ainsi que les obligations de transparence relatives à certains systèmes d’IA ne seront applicables que le 2 août 2026.

De fait, le niveau d’exigence du texte varie en fonction du niveau de risque du système d’IA considéré. Certains systèmes d’IA sont complètement interdits, tandis que d’autres sont simplement incités à se conformer à des codes de bonnes pratiques qui seront émis par le Bureau de l’IA.

Entre ces deux extrêmes, le cœur de la réglementation concerne les systèmes d’IA à haut risque, qui devront répondre à des exigences strictes en matière de documentation, de surveillance et de qualité. Les fournisseurs de ces systèmes porteront la principale charge des exigences.

En parallèle, certains autres systèmes d’IA dont la particularité est d’interagir directement avec des personnes physiques devront se conformer à différentes obligations de transparence permettent de prévenir l’utilisateur qu’il interagit avec une IA ou un contenu généré par une IA et non avec un être humain avant ou pendant son utilisation.

Enfin, la nouvelle règlementation prévoit également des obligations spécifiques à la charge des fournisseurs de modèles d’IA à usage général (GPAI) dont le périmètre est d’autant plus important que le niveau de risque systémique est élevé. Ces obligations incluent des obligations de transparence, de documentation, d’évaluation de risque et des exigences de qualité et de sécurité.

Quel est l’objectif de la loi sur l’IA ?

Le RIA vise à s’assurer que les systèmes d’IA placés sur le marché européen sont dignes de confiance c’est-à-dire licites, éthiques et robustes. Il interdit certains systèmes d’IA, impose des exigences spécifiques pour les systèmes à haut risque, impose certaines règles de transparence s’agissant des systèmes d’IA amenés à interagir avec des personnes physiques, règlemente le développement et la mise sur le marché des modèles d’IA à usage général et incite l’ensemble des acteurs au-delà des règles contraignantes édictées, à se conformer à des codes bonnes pratiques émis par le Bureau de l’IA.

“La conformité à l'IA Act est une course vers l'excellence ; ceux qui l'adoptent en pionniers façonnent un avantage concurrentiel décisif en élevant la qualité et la maîtrise des risques de leurs systèmes d'IA. C’est une stratégie des visionnaires, qui forge l'avenir de l'intelligence artificielle en Europe.”

À qui le règlement sur l’IA s’adresse-t-il ?

- Tous les Systèmes d’IA et les modèles d’IA à usage général

- Dans tous les secteurs : le règlement sur l’IA est une réglementation horizontale qui s'applique à tous les systèmes d'IA, dans tous les secteurs.

- Dans et en dehors de l'Union Européenne : le RIA s'applique à tous les systèmes d'IA opérant sur le marché de l'UE ou ayant un impact dans l'UE, même si le système est basé à l'étranger.

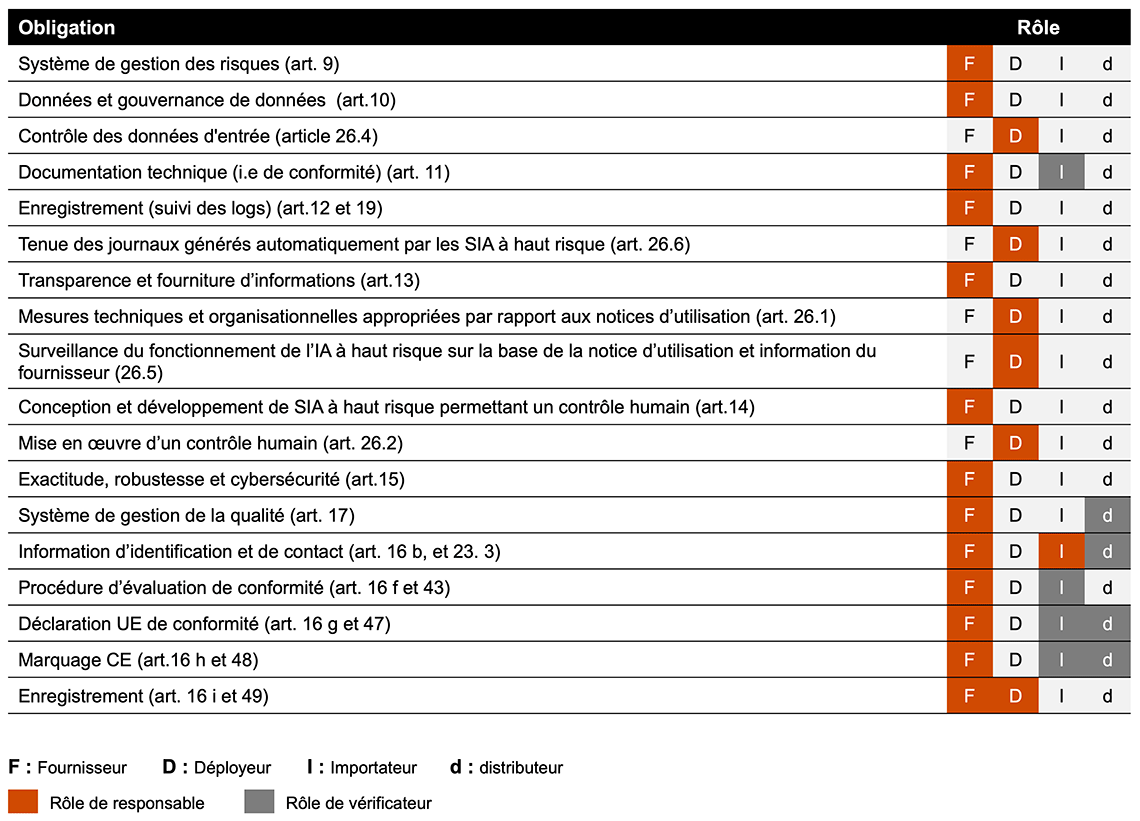

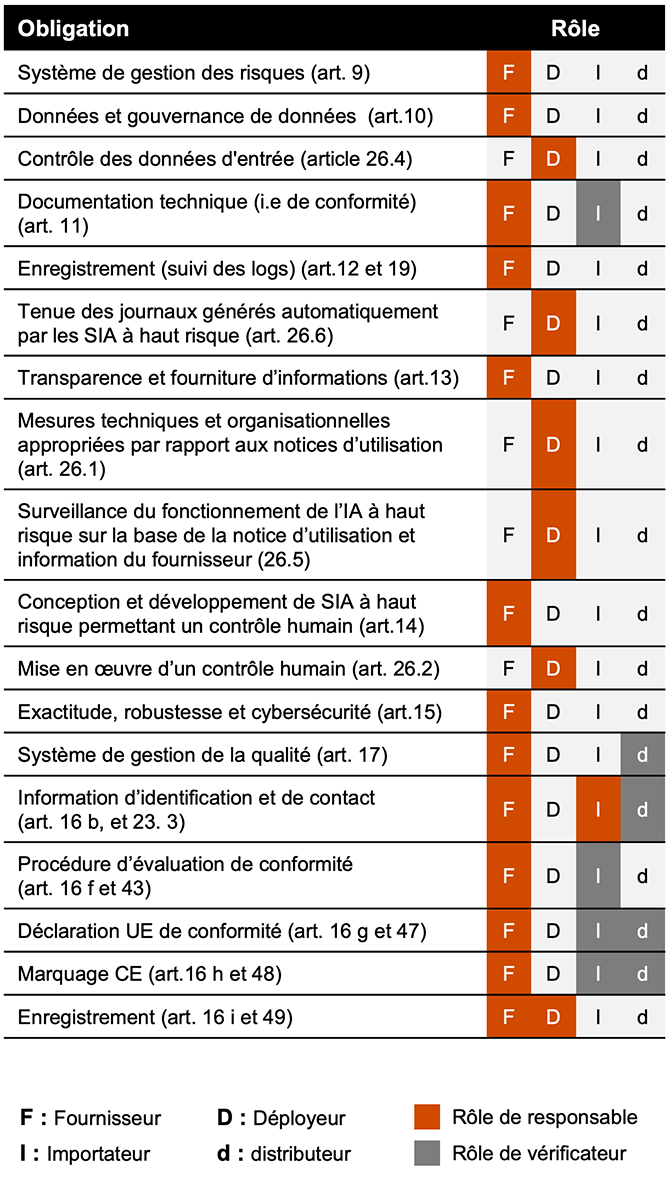

Tout au long de la chaîne de valeur de l'IA, les obligations s'appliquent aux fournisseurs, aux déployeurs, aux importateurs et aux distributeurs de systèmes d’IA ainsi qu’aux fournisseurs de modèles d’IA à usage général.

Quelles sont les exigences du RIA ?

Pour tous les systèmes d’IA (Articles 4 et 5)

Obligation d’acculturation : le fournisseur et le déployeur doivent prendre les mesures pour garantir « un niveau de maîtrise suffisant » de l’IA par leur personnel et le personnel s’occupant de leur Système d’IA pour leur compte (art. 4)

Systèmes d'IA interdits (Article 5)

Obligation de suppression des systèmes d’IA interdits, visés à l’article 5 du RIA.

Système d’IA à haut risque (section II et article 17 de la section III)

Quelles sont les sanctions prévues ?

Les autorités compétentes peuvent infliger des sanctions allant jusqu'à 35 millions d'EUR ou 7 % du chiffre d'affaires annuel mondial total réalisé au cours de l'exercice précédent.

Quel est le calendrier d’application ?

Pour transformer l'intelligence artificielle en un moteur de création de valeur durable, il est crucial d'associer qualité, réglementation et déploiement à grande échelle. Cela nécessite l'adoption de normes reconnues, de pratiques exemplaires et d'outils adaptés pour un développement et une mise en œuvre sûrs et performante des systèmes d'IA. Des systèmes de gestion des données, des risques et du cycle de vie souples et robustes sont essentiels pour permettre aux organisations de passer rapidement et en toute confiance de la phase pilote à la production massive.

« Une gestion des données rigoureuse est un fondement essentiel d'une IA responsable, conforme et fiabilisée. »

FAQ : 3 questions clés que vous devez vous poser

Est-ce que votre entreprise identifie de façon exhaustive ses systèmes d’IA ?

Afin de répondre aux exigences réglementaires du texte, il est nécessaire d’avoir, au sein de votre organisation, une définition opérationnelle claire, homogène et conforme, du système d’IA.

Une fois le système de définition mis en place, un inventaire exhaustif et précis des systèmes doit être réalisé, incluant l’évaluation du niveau de risque associé à chaque système d’IA considéré (inacceptable, haut risque, risque limité (c’est à dire certains systèmes d’IA interagissant avec des personnes physiques) et risque minimal) et la responsabilité associée endossée par l’organisation (fournisseur, déployeur, importateur, distributeur). L’inventaire produit est l’une des premières étapes dans l’évaluation de vos pratiques et l’identification des exigences applicables.

Les employés de votre entreprise ont-ils été formés aux risques associés aux systèmes d’IA et aux exigences réglementaires ?

Les différentes parties prenantes au sein de votre organisation doivent suivre des sessions de sensibilisation aux risques fondamentaux associés à ces systèmes et aux exigences réglementaires. Il s’agit là d’une exigence du texte du RIA (article 4 du RIA).

Avez-vous mis en place une gouvernance pour couvrir les risques liés aux développement et déploiement des systèmes d’IA ? Permet-elle de traiter l’intégralité de ces risques ?

Les risques associés aux systèmes d’IA peuvent se décliner selon les 3 axes suivants :

Contactez-nous

Benoît Sureau

Associé, Financial Institutions, Risk Management & Blockchain, PwC France et Maghreb